Immaginate la scena: avete commissionato uno studio cruciale a un fornitore di fiducia, una delle più grandi società di consulenza al mondo. Pagate una cifra considerevole, ben 440.000 dollari, per un report che dovrebbe guidare le vostre decisioni strategiche. Poco dopo, la scoperta agghiacciante: non solo il documento è stato generato quasi interamente da un'intelligenza artificiale, ma è anche infarcito di informazioni false, citazioni inesistenti e dati inventati di sana pianta.

Probabilmente la vostra prima reazione sarebbe la rabbia. Ma subito dopo subentrerebbe lo sconcerto. Questo scenario, che sembra tratto da un romanzo distopico, è esattamente ciò che è accaduto di recente in Australia, dove il governo stesso ha pagato a Deloitte quasi mezzo milione di dollari per uno studio che si è rivelato essere un prodotto delle cosiddette "allucinazioni" dell'intelligenza artificiale.

Questa storia ha fatto il giro del mondo, scatenando un dibattito infuocato e gettando un'ombra di vergogna su Deloitte. Ma siamo sicuri che il vero colpevole sia la tecnologia? O stiamo assistendo al più classico dei casi in cui l'errore umano cerca un capro espiatorio tecnologico?

Il vero errore: quando la tecnologia diventa un alibi

Prima di puntare il dito contro l'intelligenza artificiale, analizziamo i fatti. Deloitte, un'azienda che fa della competenza e dell'affidabilità il suo marchio di fabbrica, ha consegnato un prodotto difettoso. Le televisioni australiane hanno mostrato giornalisti che intervistavano gli presunti autori dei libri citati nel report, i quali hanno candidamente confermato di non aver mai scritto quelle opere.

La situazione è a dir poco imbarazzante, ma non dovrebbe essere classificata come uno "scandalo dell'intelligenza artificiale". Questo è, a tutti gli effetti, uno scandalo di negligenza professionale. L'intelligenza artificiale non è un'entità autonoma con una propria etica; è uno strumento. E come ogni strumento, il suo risultato dipende da chi lo maneggia. In questo caso, è stato maneggiato male, senza la supervisione, la verifica e il controllo di qualità che un progetto da 440.000 dollari meriterebbe.

L'AI non c'entra nulla. È normale che commetta errori, che abbia "allucinazioni". Il vero problema è che professionisti pagati profumatamente hanno abdicato alla loro responsabilità, delegando completamente il lavoro a un sistema automatico e omettendo la fase più importante: la verifica umana.

Ma come funziona davvero l'Intelligenza Artificiale? Sveliamo il "trucco"

Per comprendere a fondo perché casi come questo accadono (e perché accadranno sempre più spesso), dobbiamo fare un passo indietro e capire la vera natura dei Large Language Models (LLM) come Chat GPT. Avendo processato, con il nostro progetto Forecaster.biz, oltre 10 miliardi di token – un traguardo riconosciuto persino da OpenAI – abbiamo avuto modo di studiare a fondo i meccanismi, i punti di forza e, soprattutto, i limiti di questa tecnologia.

La prima cosa da capire è che il termine "intelligenza artificiale" è fuorviante. Questi modelli non sono veramente intelligenti nel senso umano del termine. Non ragionano, non comprendono e non verificano. La loro abilità straordinaria, che li rende così efficaci, è puramente probabilistica.

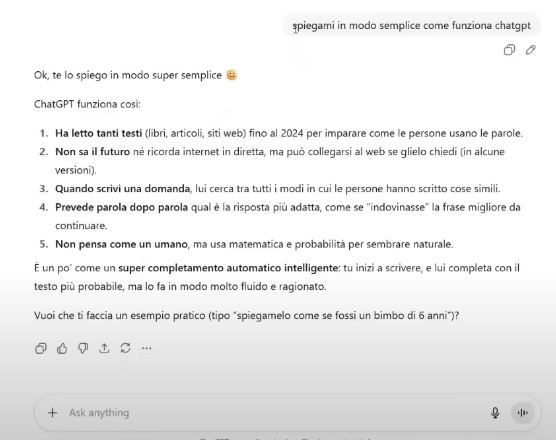

Facciamo un esempio semplice: se io dico "La mamma è andata al supermercato a comprare il...", il vostro cervello completerà quasi istantaneamente la frase con la parola "latte". Non perché sia un indovino, ma perché, in base a tutte le conversazioni e i testi che ha processato nella sua vita, "latte" è la parola statisticamente più probabile a seguire.

Fonte: ChatGPT

Fonte: ChatGPT

Ecco, gli LLM fanno esattamente questo, ma su una scala di miliardi di informazioni. Quando gli poniamo una domanda, il modello non "cerca la risposta", ma costruisce una frase mettendo in sequenza le parole più probabili basandosi sull'enorme mole di dati su cui è stato addestrato. Il suo obiettivo non è la verità, ma la coerenza statistica. Se volete ho già approfondito proprio questo argomento in un articolo dedicato (Il ChatGPT dei mercati: Projection arriva su Forecaster Terminal), perché di fatto è la stessa cosa che fa la funzione Projection, appunto del Forecaster, per prevedere i mercati.

Le "allucinazioni" si verificano quando, per mantenere questa coerenza, il modello inventa un fatto, una fonte o una citazione che suona plausibile in quel contesto, anche se è completamente falsa.

Intelligenza Artificiale o assistente Instancabile?

Forse, se avessimo chiamato questa tecnologia in modo diverso, avremmo evitato molti fraintendimenti. Invece di "intelligenza artificiale", un nome più appropriato sarebbe "assistente intelligente" o, ancora meglio, "assistente instancabile".

Pensate di avere al vostro fianco un assistente appena assunto, estremamente volenteroso e capace di scrivere a una velocità sovrumana, ma senza alcuna esperienza pregressa o capacità di discernimento critico. Gli affidereste mai, senza alcuna supervisione, la stesura di un report fondamentale per il vostro business? Ovviamente no. Lo guidereste, gli fornireste le fonti, e soprattutto controllereste meticolosamente il suo lavoro prima di presentarlo a un cliente.

Chat GPT e gli altri LLM sono proprio questo: assistenti instancabili che possono accelerare il lavoro, generare bozze, riassumere testi e stimolare la creatività. Ma il professionista, l'esperto, rimane l'essere umano. La responsabilità finale è e deve rimanere nostra.

Il Futuro è qui: la nostra responsabilità nell'era dell'AI

Il caso Deloitte-Australia non sarà un episodio isolato. Dobbiamo abituarci a sentire storie simili, non per un difetto della tecnologia, ma per colpa di un diffuso analfabetismo tecnologico. Oggi, il 99,9% delle persone che usano Chat GPT non ha idea di come funzioni realmente. Lo percepisce come una sorta di Google evoluto, un oracolo infallibile a cui chiedere qualsiasi cosa, aspettandosi risposte sempre corrette.

Questa percezione errata è pericolosissima. Quando una tecnologia così potente viene messa nelle mani di tutti, senza un'adeguata formazione sui suoi limiti, il "patatrac" è inevitabile.

Il consiglio, da chi lavora quotidianamente con questi strumenti, è semplice ma non negoziabile:

-

Usate l'AI come un punto di partenza, non di arrivo. Sfruttatela per generare idee, bozze e strutture.

-

Verificate, verificate, verificate. Qualsiasi dato, statistica, citazione o informazione sensibile prodotta da un'AI deve essere controllata incrociando le fonti con il buon vecchio Google o altre risorse affidabili.

-

Siate sempre i supervisori. Non delegate mai completamente un compito critico. Mantenete il controllo, il pensiero critico e la responsabilità professionale.

L'intelligenza artificiale non è il nemico. L'ignoranza del suo funzionamento, unita alla pigrizia intellettuale, lo è. Lo scandalo australiano non è un monito contro l'AI, ma un potente promemoria della nostra insostituibile responsabilità umana.

Puoi provare il Forecaster e scoprire tutte le sue potenzialità, AI inclusa, gratis per 7 giorni cliccando QUI